뇌졸중으로 사지가 마비되고 언어능력마저 잃은 여성 환자가 20년 만에 목소리를 찾았다. 환자의 생각을 읽는 장치를 뇌에 이식하고 인공지능(AI)으로 해독한 덕분이다. 이전에도 비슷한 실험이 성공했지만, 생각을 목소리로 바꾸는 데 시차가 있었다. 이번에는 사실상 실시간으로 음성을 구현해 마비 환자나 언어 장애 환자가 일상을 회복하는 데 크게 이바지할 것으로 보인다.

에드워드 창(Edward Chang) 미국 캘리포니아대 샌프란시스코캠퍼스(UCSF) 신경외과 교수와 고팔라 아누만치팔리(Gopala Anumanchipalli) 캘리포니아대 버클리캠퍼스(UC 버클리) 전기공학컴퓨터과학과 교수가 이끄는 공동 연구진은 3월 31일(현지시각) 뇌·컴퓨터 인터페이스(BCI·Brain-Com-puter Interface)를 이식해 뇌졸중으로 사지가 마비된 40대 여성 환자의 생각을 음성으로 구현하는 데 성공했다고 밝혔다. 연구 결과는 이날 국제 학술지 ‘네이처 신경과학’에 실렸다.

뇌 신호와 음성 구현 사이 지연 없어

BCI는 뇌와 컴퓨터를 연결해 신체 기능을 복원하거나 인간의 의도를 외부 기기로 전달하는 기술이다. 마비 환자의 뇌에 이식한 전극이 생각을 포착해 그대로 로봇이나 컴퓨터를 조작하고 문자나 음성으로 구현하는 식이다.

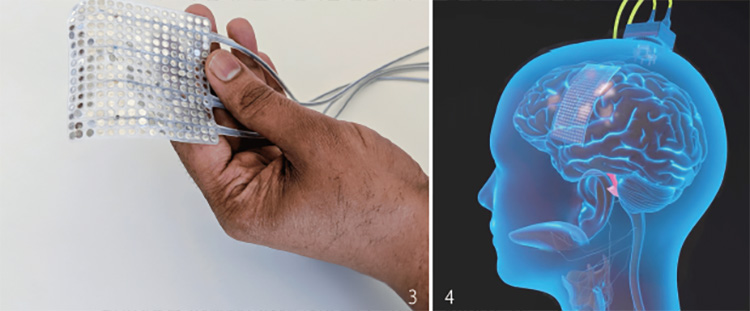

이번 임상시험에는 2005년 뇌졸중으로 사지가 마비되고 언어능력을 상실한 50세 여성 앤(Ann)이 참여했다. 창 교수는 2023년 앤의 대뇌피질 표면에 전극 253개가 들어있는 직사각형 필름 형태의 장치를 이식하는 수술을 했다. 전극은 뉴런(신경세포) 수천 개에서 나오는 전기신호를 동시에 포착했다.

연구진은 앤에게 모니터로 문장을 보여주고 그대로 말해보라고 했다. 앤은 혀와 성대를 움직이지 못해 실제 소리는 내지 못하고 머리로만 말하는 이른바 ‘침묵의 말하기(si-lent speech)’를 했다. 앤은 단어 1024개와 구문 50개로 구성된 문장 100개를 말하는 훈련을 했다. BCI 전극은 앤이 문장을 머리로 말하기 시작하기 500㎳(밀리초·1㎳는 1000분의 1초) 전부터 80㎳마다 신경 신호를 포착했다.

다음은 AI의 영역이다. AI는 앤이 특정 단어나 구문을 말하려 할 때 뇌에서 나오는 신경 신호를 파악해 생각을 문자로 구현할 수 있었다. AI는 최종적으로 문자를 음성으로 바꿨다. 특히 앤이 사고당하기 전 찍은 비디오를 이용해 원래 목소리를 구현했다. 20년 만에 목소리를 찾은 셈이다.

앞서 연구진은 2023년에 뇌 신호를 읽고 음성을 만드는 장치를 발표했으나 생각과 음성 변환 사이에 약 8초의 지연이 있어 대화하기 어려웠다. 아누만치팔리 교수는 “이번에는 문장을 보여주자 1초 안에 첫 번째 소리를 들을 수 있었다”며 “앤은 중단 없이 계속 말할 수 있었다”고 했다. 이번 BCI 장치는 앤의 뇌 신호를 토대로 분당 47~90개의 단어를 생성했다. 일반인은 분당 160개 단어를 구사한다. 앤은 다른 사람 절반 속도로 말하지만 자기 생각을 지연 없이 전달할 수 있었다.

발성 기관에 보내는 운동 신호 포착

마비 환자의 생각을 구현하는 장치는 이전부터 개발됐다. 뇌졸중이나 파킨슨병, 루게릭병(근위축성 측색경화증) 등 중증 뇌 질환으로 온몸이 마비돼 말을 못 하는 환자를 위해 다양한 기술이 개발됐다. 루게릭병을 앓다가 2018년 세상을 떠난 세계적인 물리학자 스티븐 호킹 박사는 생전 뺨 근육을 움직여 1분에 단어 10개를 컴퓨터에 입력할 수 있었다. 눈동자나 고개를 움직여 컴퓨터 화면의 커서를 옮기는 방법도 있다.

최근에는 뇌에 전극을 이식해 생각을 직접 포착하는 BCI 기술이 발전했다. 일론 머스크가 세운 BCI 업체인 뉴럴링크는 지난해 마비환자 뇌에 전극을 이식하고 컴퓨터 커서를 생각대로 움직이게 하는 데 성공했다. 이 환자는 다이빙 사고로 어깨 아래가 마비된 지 8년 만에 생각만으로 문자메시지를 보낼 수 있었다.

하지만 생각이 실제 말로 구현되는 신호를 해독하면 음성 구현 속도가 느릴 수밖에 없다. 분석할 정보도 많아 데이터 분석이 힘들다. 창 교수는 대신 뇌가 발성기관으로 어떤 단어를 말하라고 보내는 신호를 포착해 효율을 극대화했다.

논문 제1 저자인 UC 버클리 조철준 박사과정 연구원은 “생각이 언어로 변환되는 과정에서 중간에 있는 운동 신호를 가로챘다” 고 말했다.

말하자면 보안이 엄격한 상황실을 염탐하는 대신, 일선 부대로 보내는 명령문을 가로채 작전을 알아내는 방식이다. 창 교수는 앞서 2019년 뇌전증 치료를 위해 뇌에 우표 크기의 전극을 이식한 환자 다섯 명에게 책에 나오는 문장을 읽도록 하고 발성기관에 보내는 뇌 신호를 포착했다. 이를 기반으로 머리로 생각한 말을 음성으로 합성하는 것이 가능함을 입증했다. 처음엔 간질 치료용 전극을 임대해 실험했다면, 이번엔 처음부터 음성 합성을 위해 마비 환자의 뇌에 BCI용 전극을 이식했다.

말하는 감정까지 구현할 계획

대화는 일방통행이 아니다. 말할 때와 멈추고 상대방의 말을 들을 때를 알아야 대화할 수 있다. 문자로 대화하면 종종 대화가 끊기는 것도 자기 말을 하는 데 급급하기 때문이다. 연구진은 더욱 자연스러운 대화를 할 수 있도록 앤이 침묵의 말을 할 때와 말하지 않을 때 뇌 활동을 섞어 AI에 학습시켰다. 나중에 AI는 뇌 신호를 보고 언제 말하고 언제 침묵해야 하는지 파악했다.

이번 연구는 다양한 BCI 전극 데이터를 활용할 수 있다는 사실도 확인했다. 연구진은 뇌 안쪽에 전극을 삽입한 마비 환자와 성대에 전극을 이식한 건강한 지원자로부터 수집한 뇌 신호 데이터도 분석했다. 역시 AI는 생각대로 음성을 합성했다.

다만 실시간 음성 변환 연구는 참가자가 한 명에 불과한 만큼 BCI 장치의 성능과 부작용을 확인하려면, 추가 연구가 필요하다.

연구진은 “더 많은 환자가 참여하는 추가 연구가 필요하다”면서도 “언어능력을 상실한 환자가 자연스럽고 원활하게 대화할 수 있게 된다면, 삶의 질이 매우 높아질 것”이라고 말했다.

연구진은 앞으로 음성 생성기에 사용자 감정을 추가해 상황에 따라 어조나 음조·음량을 달리 만들 계획이다. 마비 환자가 가족을 사랑하는 마음을 자신의 목소리로 전달할 날이 머지않았다.